Search Console heeft nieuwe crawlstatistieken. En dat is goed nieuws, want daarmee kun je nóg beter begrijpen hoe de Googlebot jouw website crawlt. Crawlen is essentieel: een url die niet gecrawld wordt, komt niet in Google. En hoe makkelijker en sneller de bots jouw website crawlen en indexeren, hoe beter je presteert in Google. We maken je graag webwijs in de nieuwe crawlstatistieken.

Technische SEO

Zoekmachineoptimalisatie of SEO (Search Engine Optimization) bestaat uit drie pijlers: autoriteit, content en techniek. Je website moet technisch geoptimaliseerd zijn om hoog te kunnen ranken in Google. Denk aan een snelle laadtijd, makkelijk te indexeren structuur en goede leesbaarheid voor zoekmachines. Een tool die daarbij helpt is Google Search Console.

Google Search Console

Deze gratis tool van Google helpt je om je website gezond en zoekmachinevriendelijk te maken en te houden. Het platform geeft inzicht in hoe je website presteert en kan problemen in technische SEO diagnosticeren. Zo kun je op tijd issues oplossen en je ranking bewaken.

Google Search Console helpt je ook aan inzicht in je populairste pagina’s, hoe je pagina’s ranken en met welke termen je organisch verkeer kunt vergroten. En nu heeft Search Console ook een nieuw rapport: Crawlstatistieken. Wij vinden het een verborgen juweeltje. Want met de nieuwe update weten we veel meer over hoe Google jouw website crawlt en wat we kunnen doen om jou online beter te laten presteren.

Lees ook: 7 technische tips voor zoekmachine-optimalisatie in 2021

Nieuwe crawlstatistieken in Search Console

Het verborgen juweeltje vind je bij Instellingen > Crawlstatistieken openen:

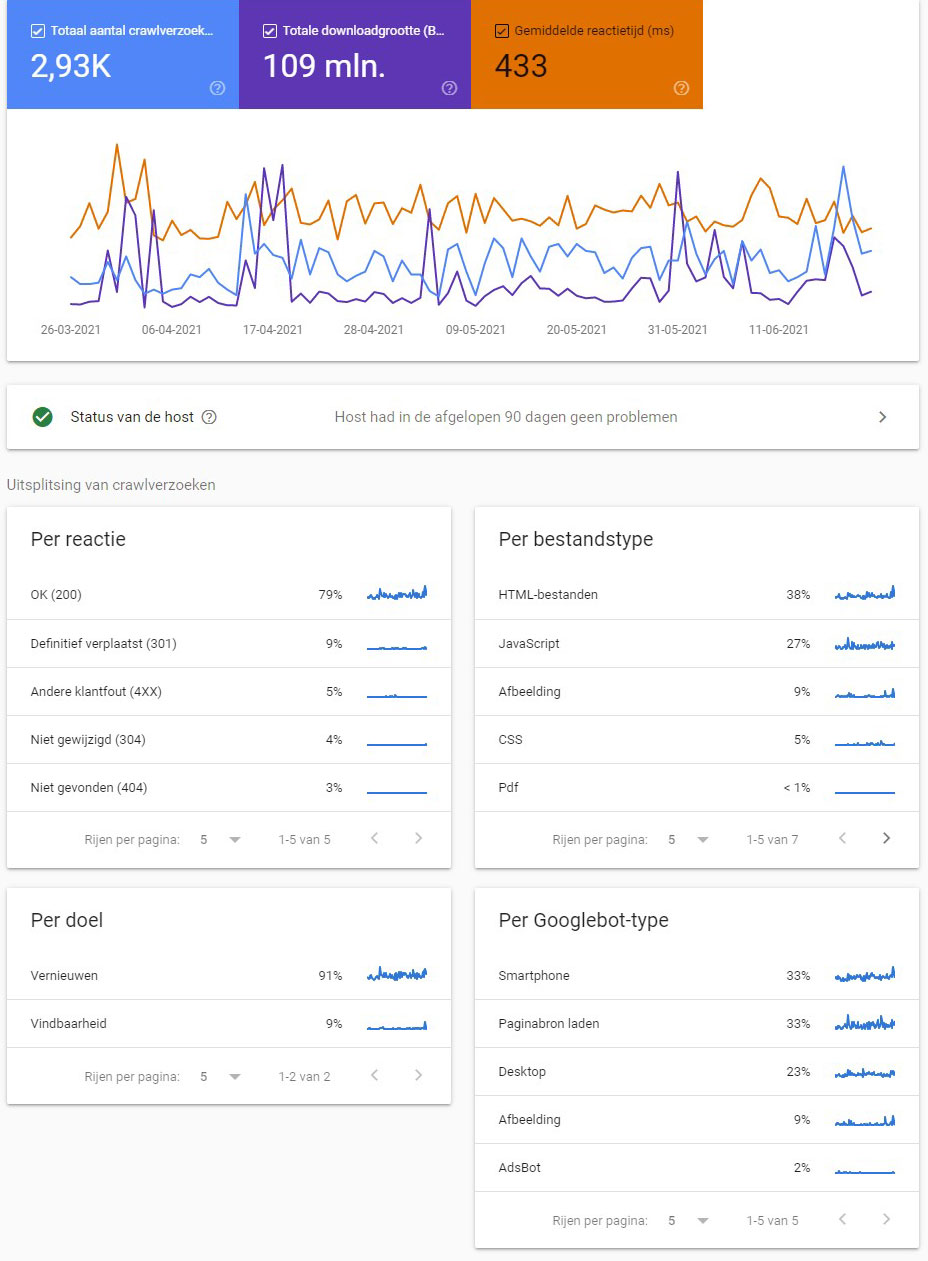

Je ziet nu in één overzicht wat de status van de host is voor jouw website. Daaronder zijn de crawlverzoeken uitgesplitst in doel, reactie, bestandstype en Googlebot-type. Zo kun je bijvoorbeeld ontdekken via welke bron de crawlverzoeken komen, zoals smartphone, desktop of afbeeldingen.

Wat heb je aan de nieuwe crawlstatistieken?

De nieuwe Crawlstatistieken van Search Console helpen je nóg beter te begrijpen hoe Google jouw website crawlt. Niet alleen voor je individuele propertyniveau, maar domeinbreed. Dus ook voor je subdomeinen.

In het nieuwe rapport zie je ook waar Google de meeste crawl-inspanning levert. Zo kun je Google sturen op het crawlen van nieuwe en bijgewerkte content en je meest belangrijke pagina’s. Ook kunnen we veel crawlproblemen sneller oplossen doordat we meer inzicht hebben in de crawlgeschiedenis. Het resultaat: sneller beter scoren in Google.

De nieuwe features

In de nieuwe Crawl stats zie je onder meer:

- Informatie over de status van de host

- Het aantal crawlverzoeken, verdeeld in:

- Responscodes (200, 301, 302, 404, etc.)

- Gecrawlde bestandstypes: (JavaScript, CSS, HTML, JSON, etc.)

- Crawldoel: vernieuwen en vindbaarheid

- Googlebot-type: Smartphone, Desktop, Afbeelding etc.

- URL-voorbeelden van waar de crawlverzoeken op je site plaatsvonden

- Een samenvatting voor eigendommen met meerdere hosts en ondersteuning voor domeineigenschappen

Hoe gebruik je de nieuwe crawlstatistieken?

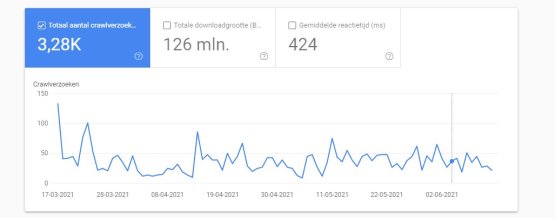

In de Crawlstatistieken zie je de Google-crawlgegevens en grafieken over langere tijd voor:

- Totaal aantal verzoeken

Hoeveel crawlverzoeken er zijn ingediend voor URL’s op je website, ongeacht of een verzoek geslaagd is of niet. - Totale downloadgrootte

Het totaal aantal bytes dat via je site is gedownload tijdens het crawlproces. - Gemiddelde reactietijd

De tijd die Google nodig heeft om alle bronnen op te halen.

Gebruik de statistieken om te beoordelen of je crawlsnelheid hoog is. Is die laag, dan betekent dit dat bots je site minder goed en minder snel indexeren.

Een daling van je crawlsnelheid kan bijvoorbeeld komen doordat je te weinig nieuwe contentupdates hebt, door defecte code of doordat je robots.txt-bestand onbedoeld bronnen blokkeert die nodig zijn om te crawlen.

Hier moet je op letten per specificatie

Status van de host

Hier kun je zien of er in de afgelopen 90 dagen beschikbaarheidsproblemen zijn geweest tijdens het crawlen van je website. Is er een probleem geweest, klik dan op ‘Reactie’ voor meer informatie daarover. Het kan zijn dat de DNS niet reageert, robots.txt niet beschikbaar is of de serverconnectiviteit problemen had.

Crawlreacties

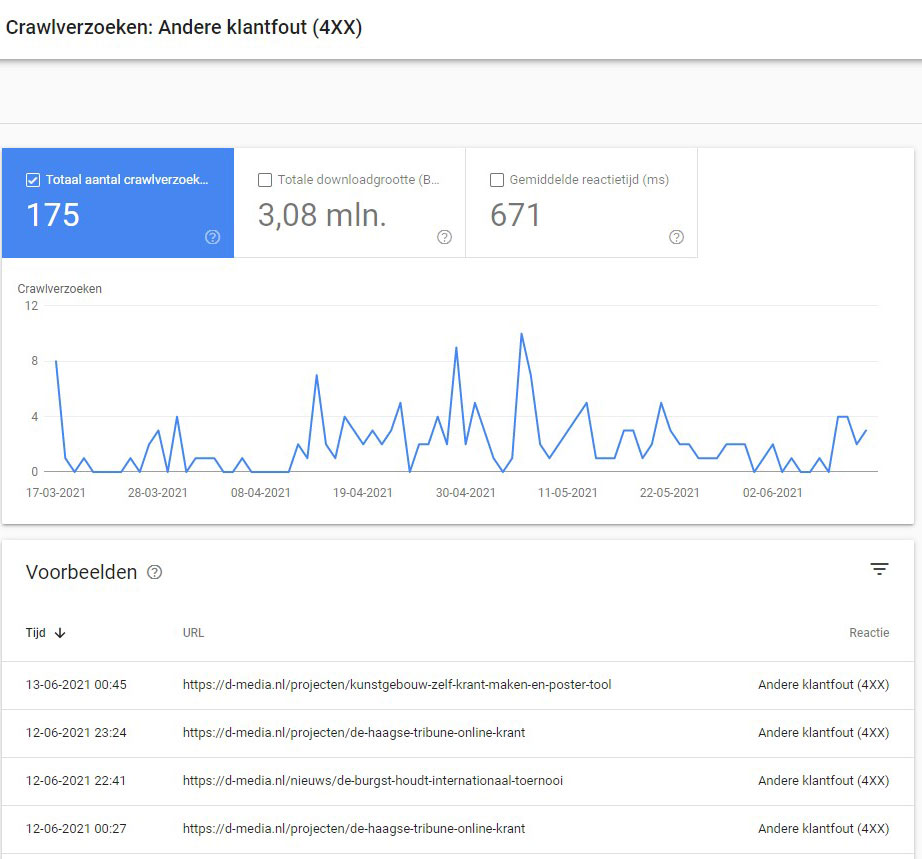

Hier zie je de reacties die Google heeft ontvangen tijdens het crawlen van je site.

De meeste reacties zouden code 200 (OK) moeten geven, of redirects zoals 301 of 302. Zie je slechte response codes, zoals 404 (niet gevonden) of 407 (niet geautoriseerd), dan kun je ingrijpen.

Bestandstype

Hier zie je de verschillende bestandstypes met hun gemiddelde reactietijd en het aantal crawlverzoeken. Zo kun je bijvoorbeeld zien of er bestandstypes zijn die crawlproblemen geven of een lage reactietijd. Op basis hiervan kun je bronnen blokkeren of juist aanpassen.

Crawldoel

Crawldoel onderscheidt de twee doelen ‘vernieuwen’ en ‘vindbaarheid’. Vernieuwen betekent dat Google een nieuwe crawl heeft gedaan van een bekende pagina, vindbaarheid betekent dat Google die URL’s nog nooit heeft gecrawld. Heb je pagina’s die vaker gecrawld zouden moeten worden omdat ze vaak een update krijgen? Dan kun je die in de sitemap laten opnemen. Voor meer statische pagina’s kun je Google verzoeken om een nieuwe crawl.

Googlebot-type

Hier zie je welke user-agent is gebruikt om de crawl uit te voeren. De meeste crawls komen van de primaire crawler, de standaard user-agent van Google. Per type zet Google verschillende Googlebots in. Check je user-agent als je crawlpieken hebt om uit te vinden waarom je crawlsnelheid te laag of te hoog is, of hoger dan anders.

Hulp nodig?

Wil je meer weten over de nieuwe Crawlstatistieken in Search Console? Raadpleeg dan de documentatie van Google of vraag het aan d-Media. Wij kijken graag met je mee in Search Console hoe jouw crawlstatistieken eruit zien en waar je winst kunt behalen.